- El modelo de lenguaje grande PaLM 2 de Google usa casi cinco veces más datos textuales para el entrenamiento que su predecesor, LLM, CNBC ha aprendido.

- Al anunciar el PaLM 2 la semana pasada, Google dijo que el modelo es más pequeño que el PaLM anterior pero utiliza una “tecnología” más eficiente.

- La falta de transparencia sobre los datos de entrenamiento en modelos de IA se ha convertido en un tema cada vez más candente entre los investigadores.

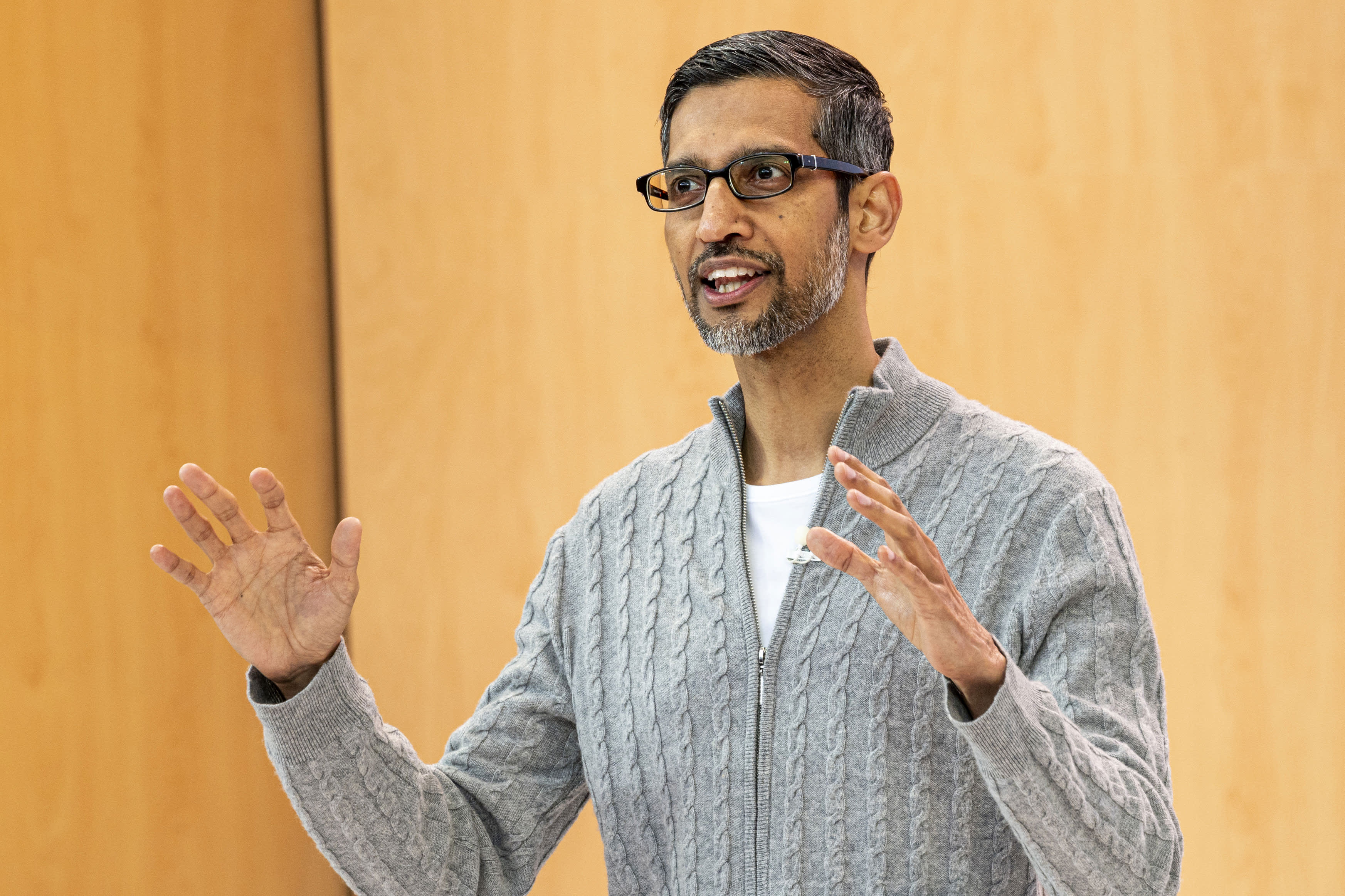

Sundar Pichai, director ejecutivo de Alphabet Inc. , durante la Conferencia de desarrolladores de Google I/O en Mountain View, California, el miércoles 10 de mayo de 2023.

David Pablo Morris | bloomberg | imágenes falsas

CNBC se enteró de que el nuevo modelo de lenguaje grande de Google, que la compañía anunció la semana pasada, utiliza casi cinco veces más datos de capacitación que su predecesor de 2022, lo que le permite realizar tareas de codificación, matemáticas y escritura creativa más avanzadas.

PaLM 2, el nuevo modelo de lenguaje grande de uso público (LLM) de la compañía presentado en Google I/O, ha sido entrenado en 3,6 billones de tokens, según documentos internos vistos por CNBC. Los tokens, que son cadenas de palabras, son un componente importante para el entrenamiento de LLM, porque le enseñan al modelo a predecir la siguiente palabra que aparecerá en una secuencia.

La versión anterior de PaLM de Google, que significa Pathways Language Model, se lanzó en 2022 y se entrenó en 780 mil millones de tokens.

Si bien Google estaba ansioso por mostrar el poder de su tecnología de inteligencia artificial y cómo podría integrarse en la búsqueda, los correos electrónicos, el procesamiento de textos y las hojas de cálculo, la empresa no estaba dispuesta a publicar el volumen u otros detalles de sus datos de capacitación. OpenAI, el innovador de ChatGPT respaldado por Microsoft, también ha mantenido en secreto los detalles del último lenguaje LLM llamado GPT-4.

Las empresas dicen que la razón de la falta de divulgación es la naturaleza competitiva del negocio. Google y OpenAI se apresuran a atraer usuarios que quieran buscar información utilizando chatbots en lugar de los motores de búsqueda tradicionales.

Pero a medida que avanza la carrera armamentista de la IA, la comunidad investigadora pide más transparencia.

Desde que reveló PaLM 2, Google ha dicho que el nuevo modelo es más pequeño que los LLM anteriores, lo cual es significativo porque significa que la tecnología de la empresa se está volviendo más eficiente mientras realiza tareas más complejas. PaLM 2 está entrenado, según la documentación interna, en 340 mil millones de parámetros, lo que es una indicación de la complejidad del modelo. El PaLM inicial está entrenado en 540 mil millones de parámetros.

Google no proporcionó comentarios de inmediato para esta historia.

Google Él dijo En una publicación de blog sobre PaLM 2, el modelo utiliza una “nueva técnica” llamada Optimización de escala computacional. Esto hace que el LLM sea “más eficiente con un mejor rendimiento general, incluida una inferencia más rápida, menos parámetros de servicio y un costo de servicio más bajo”.

Al anunciar PaLM 2, Google confirmó informes anteriores de CNBC de que el modelo está capacitado en 100 idiomas y realiza una amplia gama de tareas. Ya se está utilizando para potenciar 25 funciones y productos, incluido el chatbot experimental de la empresa, Bard. Está disponible en cuatro tamaños, del más pequeño al más grande: Gecko, Otter, Bison y Unicorn.

PaLM 2 es más poderoso que cualquier modelo existente, basado en divulgaciones públicas. LLM en Facebook se llama LLaMA, que es anunciar En febrero, se entrenó en 1,4 billones de tokens. La última vez que OpenAI compartió el volumen de entrenamiento de ChatGPT fue con GPT-3, cuando la compañía dijo que había entrenado 300 mil millones de códigos en ese tiempo. OpenAI lanzó GPT-4 en marzo y dijo que muestra un “rendimiento a nivel humano” en varias pruebas profesionales.

LaMDA, LLM conversación que Google pie Hace dos años y promovido en febrero junto a Bard, ha sido entrenado en 1,5 billones de tokens, según los últimos documentos vistos por CNBC.

A medida que las nuevas aplicaciones de IA llegan rápidamente a la corriente principal, también lo hace el debate sobre la tecnología subyacente.

Mehdi Elmohamady, científico investigador sénior de Google, Renunció en febrero Sobre la falta de transparencia de la empresa. El martes, el CEO de OpenAI, Sam Altman, testificó en una audiencia del Subcomité Judicial del Senado sobre Privacidad y Tecnología, y estuvo de acuerdo con los legisladores en que se necesita un nuevo sistema para lidiar con la IA.

“Para una tecnología que es tan nueva, necesitamos un nuevo marco”, dijo Altmann. “Ciertamente, las empresas como la nuestra tienen mucha responsabilidad por las herramientas que ofrecemos al mundo”.

— Jordan Novette de CNBC contribuyó a este informe.

El observa: Sam Altman, CEO de OpenAI, ha pedido la administración de IA

“Orgulloso adicto al café. Gamer. Introvertido incondicional. Pionero de las redes sociales”.